Fala, astronauta! Voltamos com mais uma cobertura completa do Webinar que ocorreu durante essa semana. Dessa vez, nosso mestre em SEO, Lucas Maranho, trata do assunto: o Rastreio como ninguém nunca te explicou antes.

Um desbravamento da primeira etapa do funcionamento do Google com uma explicação detalhada, didática e inovadora. Afinal, já encontrou esse conteúdo em algum outro lugar?

E nosso webinar se iniciou, como sempre, garantindo #SEOParaTodos, com a colaboração da nossa intérprete de Libras, Juliana.

Sou a Maisa e, hoje, vim te ajudar a entender como o rastreio influencia e pode afetar positivamente ou não seu site com relação ao que chega na SERP de seus usuários.

Preparados?

Rastreio, como funciona (de verdade)?

Já explicamos incontáveis vezes as três etapas do Google e como ele funciona. Mas será nossa primeira vez entrando especificamente em cada etapa. Dito isso, vamos começar recapitulando o conceito do rastreio.

De maneira muito simplificada, o rastreio é a etapa onde os crawlers “navegam” pelo site e leem o conteúdo das páginas. Após encontrar um link através da web ou do sitemap, o crawler segue os demais links através de sucessivos requests ao servidor do site.

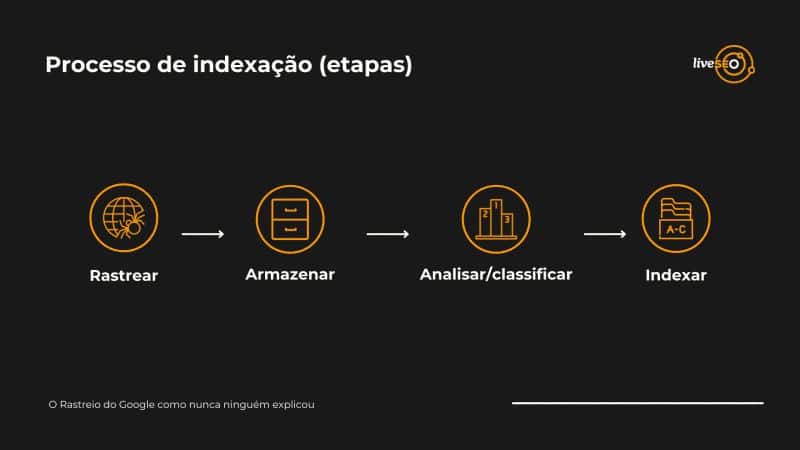

Mas é bastante simplista tratar do rastreio como uma etapa única dentro das três etapas de funcionamento do Google. Para compreender sua real complexidade, precisamos dividi-lo em outras 4 subdivisões. São elas:

- Rastreio (em si)

- Armazenamento

- Análise e classificação

- Indexação

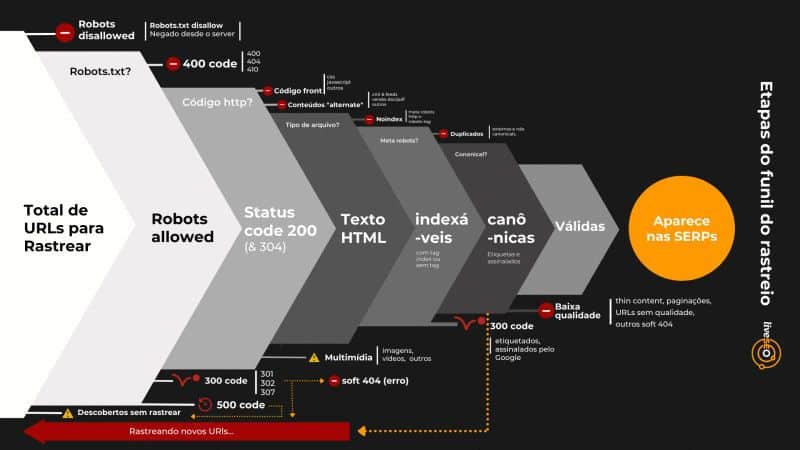

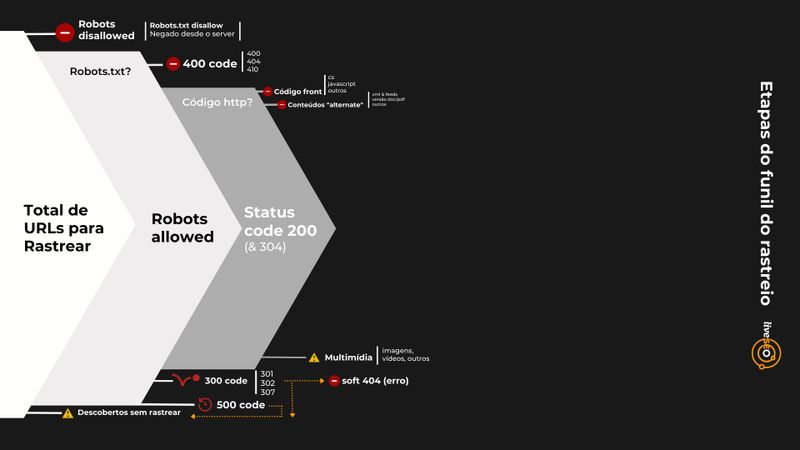

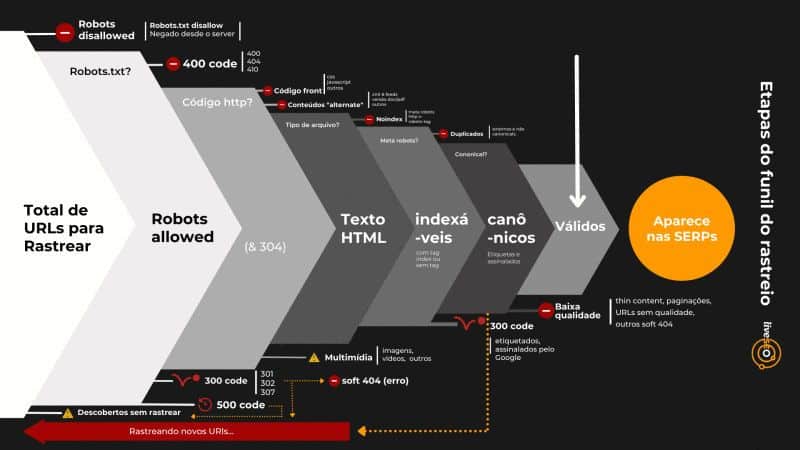

Para entendermos de uma forma visual – pois é um assunto complexo – vamos representar o rastreio como um funil, que coleta todas as informações do site e vai classificando segundo as prioridades e critérios do mecanismo de busca. O diferencial é que esse funil é, também, uma peneira: nem todos os URLs do início do processo serão levados ao ranqueamento, a fase final do funcionamento do buscador.

Por exemplo, quando você utiliza o Google Search Console e encontra URLs rastreados e não indexados, rastreados e não verificados ou apenas armazenados, podem ter ocorrido dois eventos:

- O buscador simplesmente não conseguiu rastrear a página;

- O Google rastreou a página, porém escolheu não analisá-la e indexá-la. Isso acontece com frequência em casos de thin content, conteúdos magros, sem valor ao usuário.

Urls como esses não passam pela classificação, e infelizmente não seguem para a próxima etapa, a indexação. Bora entender esse processo de verdade? Então vamos para a visualização do funil de rastreio etapa por etapa.

Processo de funil do rastreio: etapa por etapa!

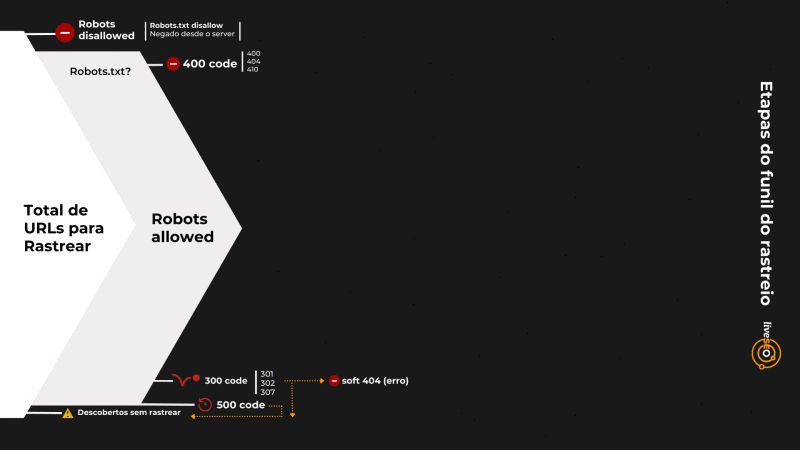

A primeira etapa do nosso funil de rastreio é o envio do total de URLs que devem ser rastreados. Mas, lembre-se, nem todos esses URLs seguirão no processo. Desse grande banco de dados, o rastreamento vai depurar aquilo que realmente faz sentido de acordo com cada etapa.

Você deve se lembrar que o Google pede para que você desencoraje o servidor de rastrear alguns URLs, e você pode realizar essa ação aplicando o disallow das páginas selecionadas. Essa é a primeira leva de URLs removidos do funil: as páginas bloqueadas pelo Robots TXT.

Robots allowed

Os URLs allowed passam para a segunda etapa, mas muitos deles não são rastreados, ou são rastreados e tem seu processo pausado ao se deparar com códigos 400 (400, 404, 410). O Google pode até encontrar essas páginas e fazer uma requisição, mas terá status code de erro, como você já conhece.

Lucas coloca que, em casos de código 301, 302 e 307 – os famosos redirecionamentos –, temos URLs descobertos, mas não rastreados (afinal, o Google identificou o URL, mas não pôde acessá-lo, já que o servidor redirecionou a ação para outra página). Você pode visualizar essas páginas no Google Search Console, onde permanecem salvas.

Algo semelhante acontece com os códigos 500, os erros de servidor. Esses casos são mais graves, e seria até possível dizer que “frustram” o buscador. Para entender essa relação, é importante definirmos o conceito de crawl budget.

Crawl budget, ou cota de rastreamento, é a maneira com que a comunidade de SEO entende o tempo que o Google destina para o rastreio de um site. É um conceito bem complexo, e até os porta-vozes oficiais do Google por vezes se contradizem ao tratar dele. Um ponto de consenso, todavia, é que o crawl budget ganha real importância apenas para sites grandes, de 500 mil URLs ou mais.

Nesses sites massivos, quando o crawler se depara com um erro 500, erro 429, ou “Too Many requests”, entende que as solicitações de rastreamento estão sobrecarregando o servidor. Para evitar problemas, passa a rastrear menos o seu site, afetando, portanto, o crawl budget. Isso com certeza trará consequências negativas que se refletirão lá no ranqueamento das páginas.

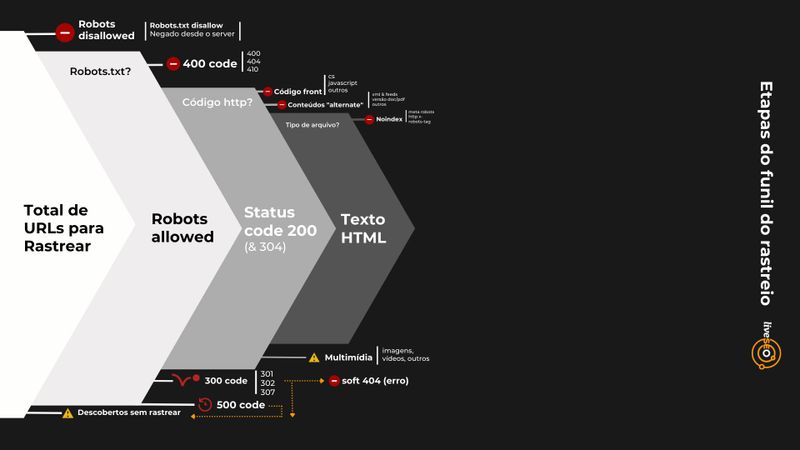

Status Code 200

Removemos do nosso funil os URLs que, por algum motivo, não puderam ser rastreados. Nos restam agora as páginas que respondem com código 200, ou seja, estão funcionais e respondem corretamente aos requests do crawler!

E nessa fase, novamente, mais elementos são removidos da futura indexação. São eles:

- Código Front;

- Conteúdos “Alternate”;

- Conteúdos Multimídia (que vão para um outro índice).

Depurados todos esses elementos, o crawler se concentra no que de fato oferecerá base semântica para a indexação. É hora de rastrear apenas o que é texto HTML.

Texto HTML

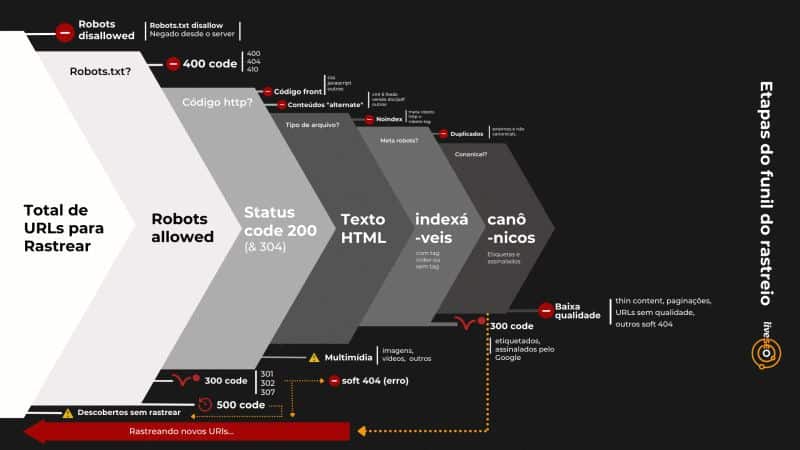

É nesse momento que ocorre a leitura do meta-robots, e são removidos de dentro do grupo das páginas HTML os URLs com tag No Index. Ficamos, portanto, apenas com as páginas indexáveis de texto HTML.

Agora que ficaram apenas as páginas indexáveis, os bots precisam entender quais URLs são duplicados ou idênticos. Nesses casos, mesmo que possuam a tag index, tais páginas não são indexadas, já que o mecanismo de busca interpreta que nenhuma delas é relevante o suficiente.

Canonicals

Ok! Temos URLs dignas de rastreio e prontas para serem indexadas. E para que o Google siga o caminho que você deseja, é preciso direcioná-lo através de tags canônicas!

A tag canonical é uma ferramenta de gerenciamento de conteúdos duplicados. A utilizamos quando desejamos que o buscador, ao tentar analisar uma página X, tome como referência uma página Y. É como se disséssemos ao Google: “essa não vale tanto a pena, vamos naquela”.

A maioria das páginas de um site possuem canonical autoreferenciado. Ou seja, quando o buscador faz o request para análise do URL, recebe a orientação de que aquele mesmo URL deve ser analisado e indexado.

Aplicando tags canonical corretamente, o Google saberá se comportar em casos de produtos variáveis. Sobre isso, o exemplo que nosso CEO traz é de um e-commerce do segmento de beleza. A palavra batom tem suas mais diversas variações em cores, por isso precisa ter uma como a principal e sua gama de variações referenciando para a URL principal. Dessa forma, no momento de rastrear, o Google sabe identificar um “fatiado de página” e pode posicionar corretamente os produtos de uma mesma família.

Durante a análise das páginas canonicals, o Google “remove” do seu funil:

- páginas thin content;

- paginações de categorias;

- URLs sem qualidade;

- páginas com soft 404.

URLs válidos

Finalmente, chegamos aos URLs válidos! Aquelas páginas que passaram pelo robots txt, responderam com código 200, possuiam texto HTML, foram denominadas canonical e apresentaram conteúdo autêntico, útil e de qualidade. Esses serão os URLs do seu site que de fato aparecerão na SERP.

Índice de Keywords: o que acontece depois do rastreio?

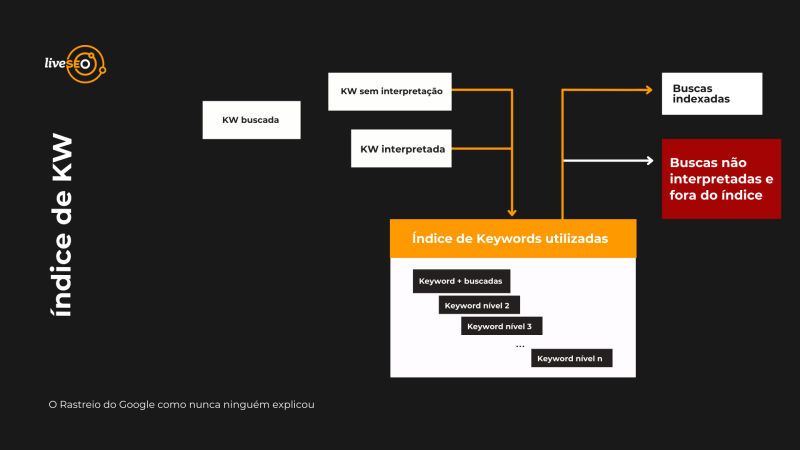

Rastreadas as páginas de acordo com todas essas etapas, o Google passa a organizá-las em índices diferentes, que atendam à diversas intenções de busca. Esses índices são fundamentais para o funcionamento da busca em si, quando um usuário submete uma query ao Google.

As keywords buscadas pelos usuários podem se dividir entre:

- KW sem interpretação (ou que não exigem interpretação): são aquelas buscas simples, realizadas com muita frequência, cuja intenção de busca é facilmente compreendida pelo Google. Não há necessidade de acionar métodos mais complexos de inteligência artificial quando buscas como essa são realizadas. Para essas querys, já existe um índice de resultados bem estabelecido e completo. No webinar, Lucas utilizou o exemplo “vestido florido”.

- KW interpretadas (ou que exigem uma interpretação mais completa): costumam ser buscas mais específicas e, por consequência, com respostas menos obvias. Alguns exemplos são buscas que misturam entidades diferentes, relacionando-as. No webinar, Lucas exemplificou com “Gisele Bundchen de vestido florido”. Esse tipo de query requer uma inteligência artificial (IA) e uma interpretação.

No segundo caso, para processar as keyowords não interpretadas, o buscador costuma unir dois ou mais indices diferentes, criando um novo índice. No caso do nosso exemplo, o novo índice criado seria a junção dos índices “Gisele Bunchen” e “Vestido Florido”.

Há casos, porém, em que a busca feita simplesmente não encontra paralelo em nenhum índice existente. Se essa query não é buscada com muita frequência, também não há motivos para a criação de um novo índice. Chamamos keywords como essas de não indexadas.

É o RankBrain que vai de forma detalhada em busca da informação mais compatível com sua busca, não só pelos índices disponíveis, como também por todas as informações armazenadas lá do início do processo de rastreio e afunilamento.

O que acontece se tenho palavras-chave sem busca e que não tem como serem interpretadas pelos bots?

Eles farão uma busca no armazenamento, já que os índices com palavras mais buscadas não são capazes de servir como resultado para sua pesquisa. Nesses casos, são entregues como resultado de pesquisa os conteúdos mais recentes com menções exatas ao elemento buscado.

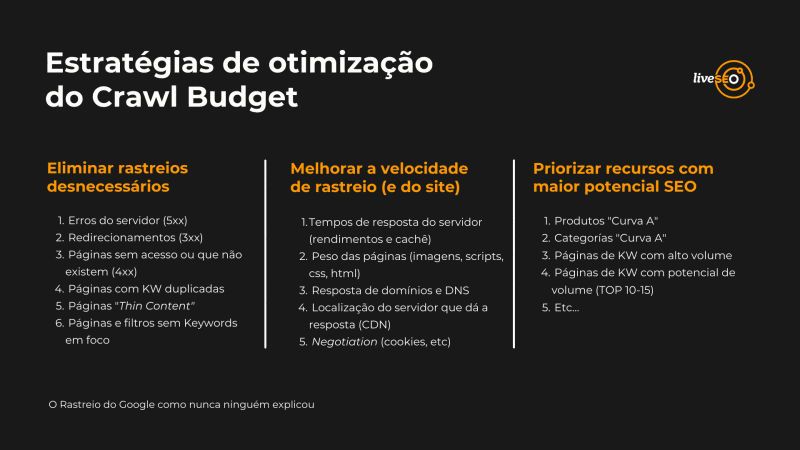

Estratégias de otimização do Crawl Budget

Algumas estratégias que podem ajudar na otimização do tempo que os crawlers levam para ler seu site.

Eliminar rastreios desnecessários

- Erros de servidor

- Redirecionamentos

- Páginas sem acesso ou que não existem

- Páginas com KW duplicadas

- Páginas “Thin Content”

- Páginas e filtros sem KW em foco

Melhorar a velocidade de rastreio (e do site)

- Tempos de resposta do servidor (rendimentos e cachê)

- Peso das páginas (imagens, scripts, css, html)

- Respostas de domínio e DNS

- Localização do servidor que dá resposta (CDN)

- Negotiation (cookies, etc)

Priorizar recursos com maior potencial SEO

- Produtos “Curva A”

- Categorias “Curva A”

- Páginas de KW com alto volume

- Páginas de KW com potencial de volume (TOP 10-15)

- Etc…

Esclarecendo dúvidas pertinentes sobre rastreio

Como em todos os webinars, tivemos aquela troca interessantíssima com nosso público. A seguir, você confere um pouco da sessão de perguntas e respostas conduzida pelo Lucas!

“Esse afunilamento é feito de tempos em tempos ou é feito toda vez que uma URL é criada?”

Para explicar isso, Lucas nos conta do conceito de sandbox criado pela comunidade de SEO. O termo começou a ser usado quando os webmasters notaram que, após a criação de uma página, levava certo tempo até que ela fosse rastreada e indexada. Imaginava-se, portanto, que o site estava passando por uma “punição”; que havia sido colocado em uma “caixinha de espera” até que o buscador pudesse entender se era um bom site ou não.

Hoje, sabe-se que o Google renova o seu índice geral em ciclos de cerca de 28 dias. Por isso, é natural que uma página criada logo após a atualização mais recente do índice leve até 28 dias para aparecer nos resultados de busca. Pode ficar tranquilo: seu site não está passando por uma punição.

Para responder a pergunta de forma mais direta, Lucas afirma que sim, todas as vezes que um novo URL é submetido ao sitemap, será lido pelo fresh crawl do site (ou seja, o rastreio diário do Google). De tempos em tempos (ou quando seu site sofre alterações mais robustas), o deep crawl é acionado. Nesses casos, o rastreio é bem mais aprofundado e detalhado.

“Há algum problema em não colocar canonicals autorreferenciadas? Deixar sem, mesmo”

Falando em um cenário de maturidade onde o SEO já é praticado a aproximadamente 3 ou 6 meses, onde já foi possível corrigir todos os problemas mais fáceis, devemos sim aplicar canonicals a tudo. Com a falta dessa prática, você basicamente deixa a critério do Google, que pode simplesmente “pular” essa etapa do funil por não julgar necessário.

“O que acontece e como devem ser aplicadas as (/) no final das urls tanto em diretórios como páginas de detalhes do produto desde o início de uma web? Para melhorar o Crawl Budget, claro!”

Temos uma série de sites que, quando clicamos no URL, ele nos redireciona para uma página com slash. E isso é negativo, pois se trata de um redirecionamento.

Então, construiu com barra? Deixe a barra. Construiu com barra? Mantenha sem barra! Evite redirecionamentos, e lembre-se que o objetivo do URL é ser sempre amigável.

“Subi meu sitemap e tenho páginas válidas e excluídas. Por que foram excluídas?”

Como dito anteriormente, uma causa pode ser a exclusão durante o rastreio. O bot pode ter julgado essas páginas irrelevantes, com thin content e de baixa qualidade.

“É mais importante atualizar conteúdos antigos ou produzir novos?”

Isso depende das necessidades do seu site. Como sua página se comporta diante dos conteúdos que produz? Se o seu nicho for repleto de conteúdos temporais, que se alteram constantemente – como uma lei trabalhista, por exemplo – as chances de rankeamento de conteúdos antigos são baixas, já que muitos concorrentes estão soltando conteúdos novos o tempo todo. Então, você pode atualizá-los e pontuar essas mudanças no texto.

Se for do seu campo semântico e você tiver temática, crie conteúdos novos. E claro, com relevância!

“Como corrigir esses erros: ‘o campo review não foi encontrado ou campo aggregateRating não foi encontrado’?”

Esses erros são de dados estruturados, e fala que a plataforma tem avaliação e review, mas o Google não encontrou esses dados de forma estruturada. Podem ser considerados avisos, e não erros.

“Qual a melhor forma de criar um sitemap automaticamente”

A melhor forma é criar manualmente, deixando uma plataforma com uma série de tickets designando o que você quer que seja gerado ou não no seu sitemap.

“O que fazer com as páginas de erro 404 quando existem páginas que não foram redirecionadas no processo de migração”

Existem duas formas de encontrar páginas 404: no Google Search Console ou dentro de seu site. Quando o Google rastreia seu site e encontra páginas com 404, significa que há links desatualizados que devem ser trocados. Por padrão, mesmo que a migração seja antiga, é recomendado um redirecionamento.

Quando o Google encontra URLs 404 pelo GSC, mesmo que ela não esteja mais no seu site, ele está apresentando que existe um url que um dia ele armazenou e até possa ter tentado indexar, mas você já não possui essa página e ele não pode mais rastrear. Então, ele te questiona dentro da ferramenta.

Se estiverem dentro do seu site, atualize o link e redirecione. Caso um dia você recebeu um backlink antes de virar 404, poderá aproveitar essa autoridade para uma página similar.

E ficamos por aqui. Mais uma viagem repleta de conhecimento com uma explicação técnica de ponta! Ficou com alguma dúvida? Deixe aqui nos comentários que a gente te dá todo o suporte.

Câmbio, desligo!