Recentemente, um vazamento de informações internas do Google revelou insights valiosos sobre como os algoritmos de busca realmente funcionam. Essa é uma oportunidade única para entender os mecanismos por trás dos critérios de ranqueamento e ajustar suas estratégias para obter melhores resultados.

No webinar com o Head de SEO técnico, Henrique Zampronio, você conhecerá as principais revelações dos leaks do Google, impactos no SEO e técnicas para otimizar o seu site com base nos novos insights. Boa leitura!

O que são os leaks do Google?

O que chamamos de Google leaks é o vazamento de uma série de documentos sobre as chamadas de API do Google Search, Maps, Cloud, Youtube, entre outros produtos da gigante da tecnologia. São mais de 2 mil arquivos de módulos de API e mais de 14 mil parâmetros de funcionamento do mecanismo de busca.

Os registros datam de outubro de 2022, mas apresentam informações relevantes até meados de agosto de 2023. O vazamento acidental revisitou muitos detalhes relacionados a como o buscador de fato opera e algumas novidades sobre os critérios de ranqueamento.

De acordo com estudiosos desse material, como Mike King, existem pelo menos 7 mil parâmetros relacionados ao Google Search e quase 8 mil que afetam o ranking. O próprio Google reconheceu a veracidade das informações e os seus milhares de documentos são analisadas pela comunidade SEO em todo o mundo.

Como o mecanismo de busca funciona?

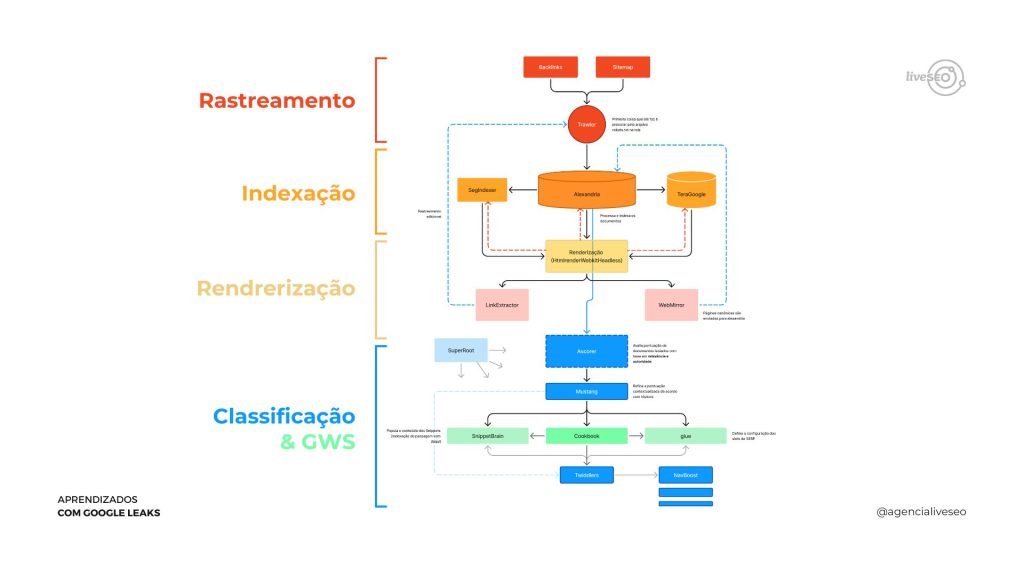

Para compreender como essas informações afetam realmente o desempenho de um domínio, é preciso retomar o funcionamento do Google desde o princípio. De maneira geral, o processo de apresentar um URL na página de resultados envolve quatro etapas: descoberta, rastreamento, indexação e classificação com base em relevância e autoridade.

Quando os crawlers descobrem e rastreiam o seu site, as informações são armazenadas em seu índex, como uma sala de arquivos internos do Google. Depois, ele encontra palavras-chave correspondentes ao conteúdo que você publicou, fazendo com que você apareça na SERP, caso cumpra com os seus critérios de ranqueamento.

É claro que esse procedimento envolve diversas etapas e análises, mas, na prática, os documentos internos do Google complexificam ainda mais o conhecimento que a comunidade SEO tinha sobre o mecanismo de busca. Alguns fatores e regras que ainda eram nebulosos ou indefinidos foram esclarecidos e detalhados sobre o que a ferramenta considera na hora de classificar uma página.

O que muda no entendimento sobre o Google com os novos dados?

O Google leaks apresentou à comunidade de especialistas em SEO novos nomes e processos que antes eram indefinidos, principalmente na etapa de indexação e ranqueamento. A começar pelo termo usado para se referir aos crawlers: nos arquivos, eles são chamados de trawler, navio pesqueiro em inglês. O diagrama mostra como acontece o processo de descoberta a partir do início do trawler (backlinks e sitemaps).

Os dados coletados são armazenados em Alexandria, uma referência direta à maior biblioteca do mundo. Lá, o componente SegIndexer, assume o papel de segmentar esses conteúdos com base em contexto. Ele armazena dados de Page Rank, sinais de relevância e faz a correspondências padrão com intenção de busca em relação ao layout do resultado, entre outros dados importantes que serão considerados posteriormente no processo de classificação.

Durante o processo de classificação, destaca-se o algoritmo Mustang, que refina o ranqueamento de sites e documentos (páginas) com base no score individual atribuído previamente pelo Ascorer. O Mustang realiza o re-ranqueamento considerando diversos sinais, como o contexto, o valor da entidade, a intenção de busca e o comportamento do usuário.

- Cookbook: compreende os dados estruturados e personaliza o layout da SERP com base na intenção de busca do usuário;

- Glue: anteriormente conhecido como Everflux, ele identifica a intenção da busca e define os slots da SERP;

- Twiddlers: algoritmos que rearranjam dados para determinar relevância das páginas;

- Navboost: twiddler que analisa o comportamento e satisfação do usuário, considerado um dos sistemas mais importantes do Google.

Conheça as 6 principais descobertas com o Google leaks

O Google leaks trouxe novos parâmetros e operações que podem impactar as estratégias SEO. Por isso, separamos as principais novidades para você se aprofundar nessas descobertas com a gente:

1. Dados são coletados do Chrome

Antes era incerta a origem da coleta de dados usado para refinar a operação do Google e influenciar a dinâmica da SERP. Muitos especialistas em SEO consideravam que essas informações eram retiradas do Analytics, mas não existe sequer uma evidência nos documentos que os dados da ferramenta são utilizados.

Os documentos sugerem que o mecanismo utiliza muitos dados colhidos do Chrome, o navegador do Google, lançado em 2008, para potencializar o seu grande algoritmo de busca. Entre os exemplos, estão o Chrome Counts, Instant Vills, Chrome Trans Click, entre outros componentes.

2. Navboost como grande sinal

A maior novidade é o esclarecimento de que o comportamento do usuário influencia diretamente nos resultados. O Navboost é um sinal de ranqueamento essencial que observa como os usuários interagem com as buscas no Google.

Ele utiliza os dados do Chrome para fazer a classificação das URLs, conforme a correspondência com a intenção de busca. Ainda é incerto se o twiddler interage com o Glue ou com outras fontes para extrair essas informações. Na prática, ele funciona da seguinte forma: quando você faz uma pesquisa no mecanismo, o Google começa a acompanhar o seu comportamento.

Se você clicou no 1º resultado da SERP, não gostou do que viu, clicou no 2º resultado e ficou por mais tempo, essa informação é enviada ao Navboost com o indicativo de que a 1ª página acessada não está respondendo corretamente à intenção do usuário.

O algoritmo conta com uma metodologia própria, ainda desconhecida, para definir os fatores de classificação, o que não é refletido diretamente nas métricas de taxas de rejeição ou engajamento do Analytics e outros canais.

Os documentos ainda ressaltam que a análise do Navboost considera alguns outros fatores, como cliques bons e ruins, impressões, Last Longest Clicks, cliques unicórnios, entre outras métricas.

3. Menções valem mais do que esperávamos

O Google conta com módulos de processamento de linguagem natural (NPL), incluindo SAFT e Entity, o que significa que ele compreende contexto, significado e sentimentos em um texto. Ele consegue identificar e interpretar relações complexas de referências para um domínio relacionado à entidade.

Muito além de backlinks, as menções são o reforço de que a sua entidade é referência em um assunto. Mais do que nunca, a necessidade de trabalhar o fortalecimento da marca para garantir relevância em um nicho é crucial para uma estratégia SEO efetiva.

Leia também — SEO semântico: como o Google lê e entende um conteúdo.

4. Demotions ou fatores de rebaixamento

Os demotions usam sinais de diferentes canais para avaliar diversos fatores negativos que impactam na experiência do usuário em um site, refletindo no desempenho da página. Menos agressivos que as penalidades, eles afetam diretamente no score e podem gerar o rebaixamento do domínio.

Entre os alertas, estão:

- Experiência navegacional pobre;

- Confiabilidade a partir da avaliação do produto;

- Anchor text que não corresponde com o conteúdo da página;

- Insatisfação do usuário com a página (bad clicks);

- Links tóxicos;

- Frequência suspeita de novos anchors em novos domínios.

Em alguns casos, como no anchor spam, o demotion pode levar à penalização, afetando todo o site, não apenas partes dele.

5. Topicalidade desviada pode ser sinal de spam

Como a relevância de um domínio é fator essencial para conseguir um bom posicionamento da página de resultados, é preciso que o seu site seja um especialista no seu nicho. A topicalidade desviada, ou seja, publicar sobre diferentes conteúdos e assuntos que fogem da sua área, só para conquistar mais palavras-chave e se iludir com um potencial crescimento, pode ser sinalizada como prática de spam.

É necessário adotar a estratégia de planejamento de conteúdo e otimizar as suas páginas em relação a um nicho específico. O foco em um tópico melhora o seu desempenho geral, aumentando a sua esfera de influência e pontuação do site no Google.

Salve para assistir depois — Google EEAT: o que é e qual o impacto para SEO.

BÔNUS: Cluster IDs

O Google conta com uma API que organiza os documentos em cluster IDs, considerando páginas com conteúdos semelhantes, mas não idênticos, para evitar canibalização. São exemplos disso a paginação de seções, páginas traduzidas, entre outras. Isso significa que dentro da Alexandria, essas URLs não são considerados duplicados naestrutura do Google.

Já era de conhecimento da comunidade de SEO que atribuir URLs canônicas em paginações prejudicava o rastreamento do conteúdo paginado. Alguns profissionais ainda hesitam em permitir que as paginações sejam tratadas como canônicas, temendo a canibalização. No entanto, os documentos sugerem que, desde que a paginação siga uma sequência e parâmetros claros, não se preocupe com a atribuição de URLs canônicas para a primeira página.

Como o Google leaks impacta nas estratégias SEO?

O vazamento de documentos que detalham como o mecanismo de busca realmente funciona é essencial para otimizar os resultados. Além disso, a revelação do peso do ranqueamento deve ser priorizada cada vez mais nas estratégias SEO.

Entenda como você pode aplicar as informações do Google leaks na prática:

1. SEO e UX

A otimização das páginas para os buscadores deve se basear em proporcionar a melhor experiência ao usuário. O Google prioriza sites que entendem as necessidades dos visitantes e resolvem suas respectivas dores.

Investir em um bom UX, layouts intuitivos, ícones navegacionais e ponderar o uso de scroll infinito pode facilitar o processo de navegação e engajar os usuários de maneira mais efetiva. Os Core Web Vitals continuam sendo métricas cruciais para a performance do seu site, considerando a velocidade de carregamento, e devem ser olhados com mais ênfase na sua estratégia.

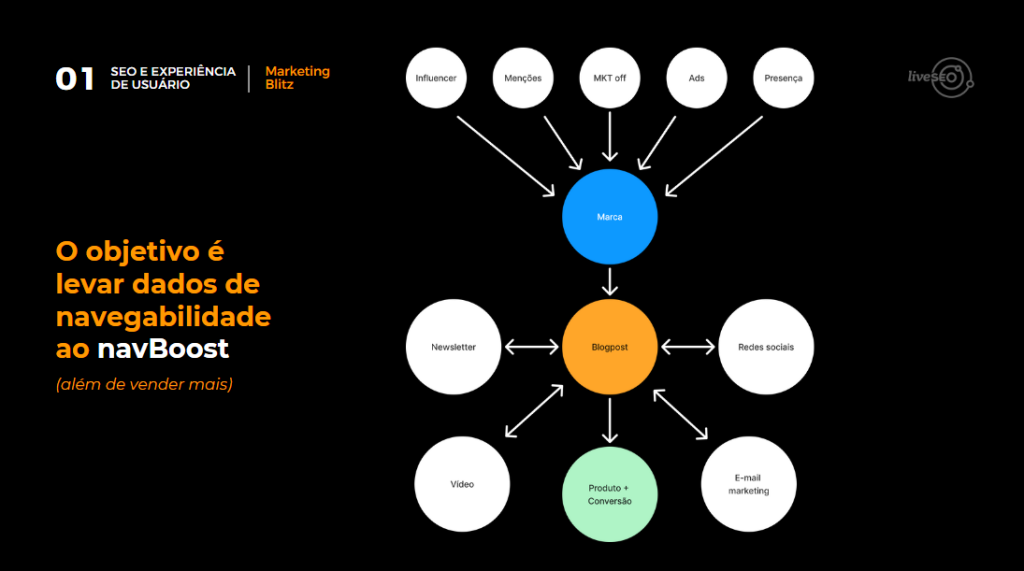

Além disso, o marketing blitz é um recurso que contribui para as pessoas navegarem cada vez mais no seu conteúdo, trazendo dados de navegabilidade para o Navboost, que poderá levar a sua página para o topo da página de resultados. Para isso, é preciso que o seu conteúdo seja relevante para o público-alvo e que você consiga trazer usuários qualificados para o seu site, combinando estratégias online e offline.

2. Ajuste de topicalidade

Manter a topicalidade é crucial para o seu site ter um bom desempenho no ranking do Google. Seja um domínio com caráter transacional, navegacional ou informativo, é necessário compreender o seu nicho e os assuntos que têm relação com o seu público.

O planejamento de conteúdos em tópicos é uma estratégia muito conhecida na comunidade SEO e deve ser ainda mais valorizada. A criação de um blog direcionado a um nicho específico pode aumentar a relevância e alcance dos produtos, além de contribuir para a construção da expertise do seu domínio.

Evite emitir sinais de spams com vetores e páginas que se distanciam do tópico que classifica o seu negócio. Invista em estratégias de topic clusters, content pruning e outras ferramentas que organizam o seu site para reforçar o EEAT, a influência e pontuação no Google.

A lógica dos vetores funciona da seguinte maneira: na clusterização, há o mapeamento dos tópicos do seu nicho para entender onde eles estão posicionados. A partir disso, é identificado, matematicamente, onde o seu site está posicionado em um gráfico bi ou tridimensional que representa o quanto seu conteúdo se aproxima desse vetor a ser alcançado.

Quanto mais você produz conteúdos fora do seu nicho, mais você se distancia desse objetivo. Por outro lado, quanto mais relevância e autoridade você constrói sobre um tópico, mais o seu domínio se aproxima do vetor e a sua “bolinha” aumenta de tamanho.

3. Investimento em otimizações de rastreamento e renderização

Para além de organizar as suas páginas estrategicamente para atender às intenções e necessidades do usuário, é vital que o seu domínio seja rastreado e renderizado corretamente pelo mecanismo de busca. Sem isso, ele não conseguirá ler e interpretar adequadamente a estrutura do seu site.

Entender como seu site opera é fundamental para uma otimização eficaz. A relação entre páginas deve ser clara para facilitar a indexação pelo Google. Quando melhor for o rastreamento e renderização, melhor poderá ser a análise do Mustang e Twiddlers.

Ainda há muitos documentos e parâmetros que precisam ser analisados e compreendidos para aprofundar nosso entendimento sobre o funcionamento do Google e otimizar a estratégia para alcançar máxima eficácia.

Estude você mesmo os documentos e contribua para fortalecer a comunidade de SEO no Brasil!

Continue com a gente para explorar outros conteúdos e webinars sobre o universo SEO. Por aqui, você também confere como analisar os indicadores para cada etapa de um projeto SEO. Te esperamos lá!