Quão tedioso é precisar dar mais de 5 cliques para chegar a uma determinada página de um site? Se pra você já é ruim, imagine para os crawlers!

Hoje quero te levar para um assunto muito interessante e relevante no nosso SEO Universe. Cheque seu equipamento, e bora imergir, afinal, vamos falar de Crawl Depth — pela primeira vez em português!

O que é Crawl Depth?

Crawl Depth é uma medida de eficiência de rastreamento. Diferente do Crawl Budget ou orçamento de rastreio, nesse caso, o Google não está levando em conta quanto tempo o buscador demora para explorar seu site, mas sim quão longe ele é capaz de chegar durante um único rastreio.

Por isso o conceito de Crawl Depth é chamado assim, já que traduzido do inglês significa profundidade de rastreio. Ele está diretamente relacionado com a arquitetura do site, já que é ela quem pode aumentar ou diminuir o Crawl Depth.

Muitas vezes, pensando em melhorá-la, são feitas hierarquizações nos conteúdos e categorias das páginas, mas isso pode ser bastante prejudicial, já que o buscador precisaria de um tempo maior no processo de indexação de todos os links. Você consegue enxergar como os conceitos que eu trouxe são pertencentes um ao outro?

Como um conteúdo chega até a SERP – ou como o Google funciona

É sempre importante dar um passo atrás para poder ver de uma perspectiva mais clara e inteligente novos conceitos, baseado em nossas antigas concepções. Por isso, voltamos a falar sobre como o Google rastreia, indexa e ranqueia um site.

A primeira etapa, o rastreio, é quando o Google identifica seu site a partir de links que levam até ele ou pelo Google Search Console, por um pedido do próprio proprietário do site.

A partir desse momento, todos os links, documentações, códigos e conteúdos são rastreados e prontamente armazenados em seu grande banco de dados. A ação de “guardar” as informações em um banco de dados é a segunda etapa, a indexação.

A última etapa, o ranqueamento, leva inúmeros fatores pertinentes — alguns amplamente divulgados e outros não — para decidir quem estará ocupando a primeira, a segunda ou a terceira posição do Google (e assim vai).

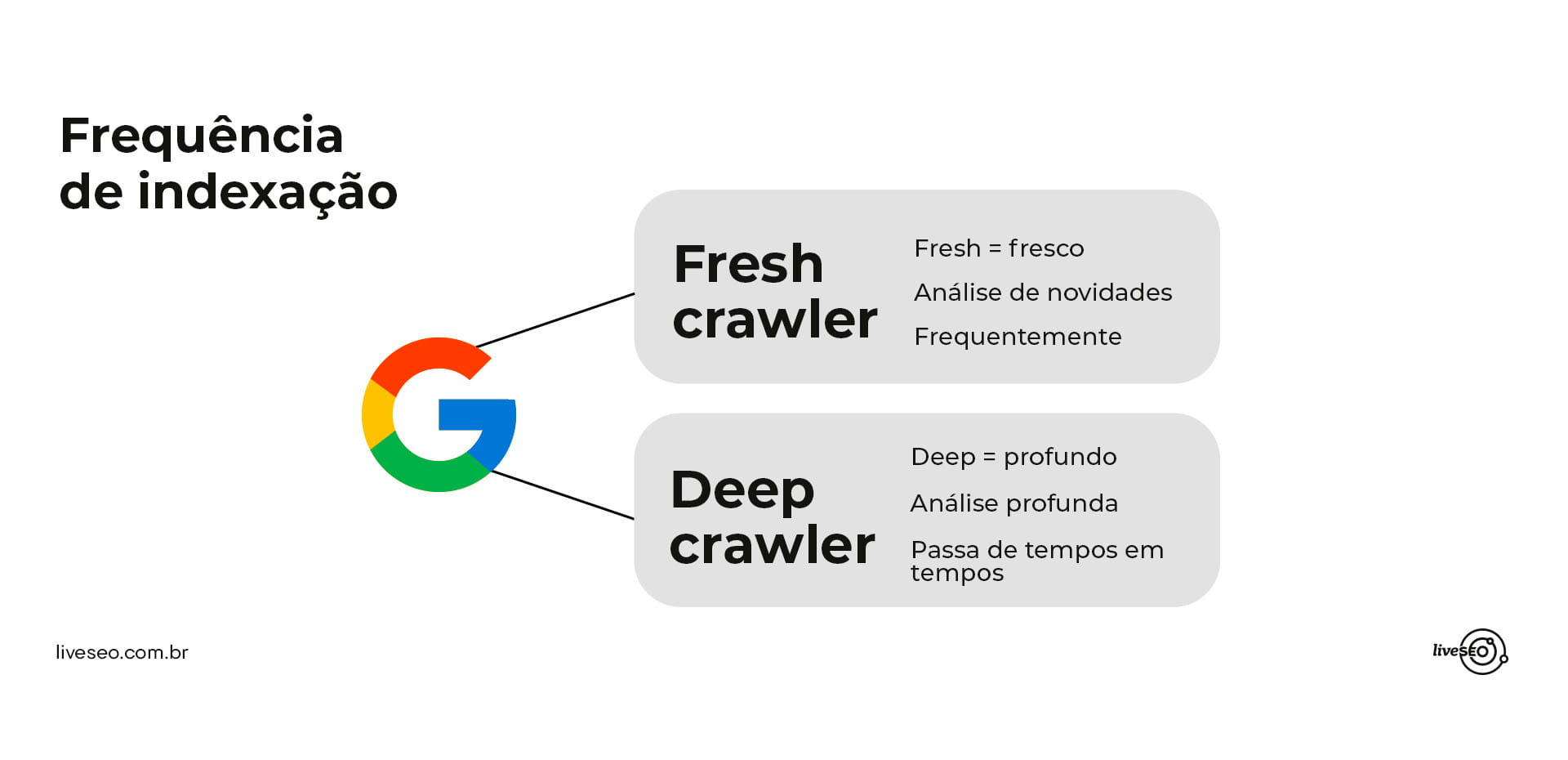

Com que frequência o Google indexa um site

Todos os dias os crawlers trabalham e se deparam com uma grande carga de novos conteúdos, afinal, se existem 3,5 bilhões de pesquisas diárias, existem novas respostas!

Então, a cada novo URL que é submetido dentro do sitemap, ele é lido por um Fresh Crawler, um bot que passa todos os dias “checando as novidades”. O Deep Crawler acontece de tempos em tempos e vem para realizar um rastreio mais profundo e detalhado caso identifique mudanças mais robustas dentro do site.

Imagine que chega um desses momentos em que o Deep Crawler precisa passar pelo seu site, mas existem muitos níveis de profundidade e pouco orçamento para um rastreio… Não soa um pouco incongruente?

Por isso, o indicado é planejar e organizar a arquitetura do site de uma forma que favoreça ambos aspectos.

Se você quiser entender melhor o rastreio do Google, faça a leitura desse conteúdo e assista ao nosso webinar: https://liveseo.com.br/videos-de-seo/rastreio-do-google/

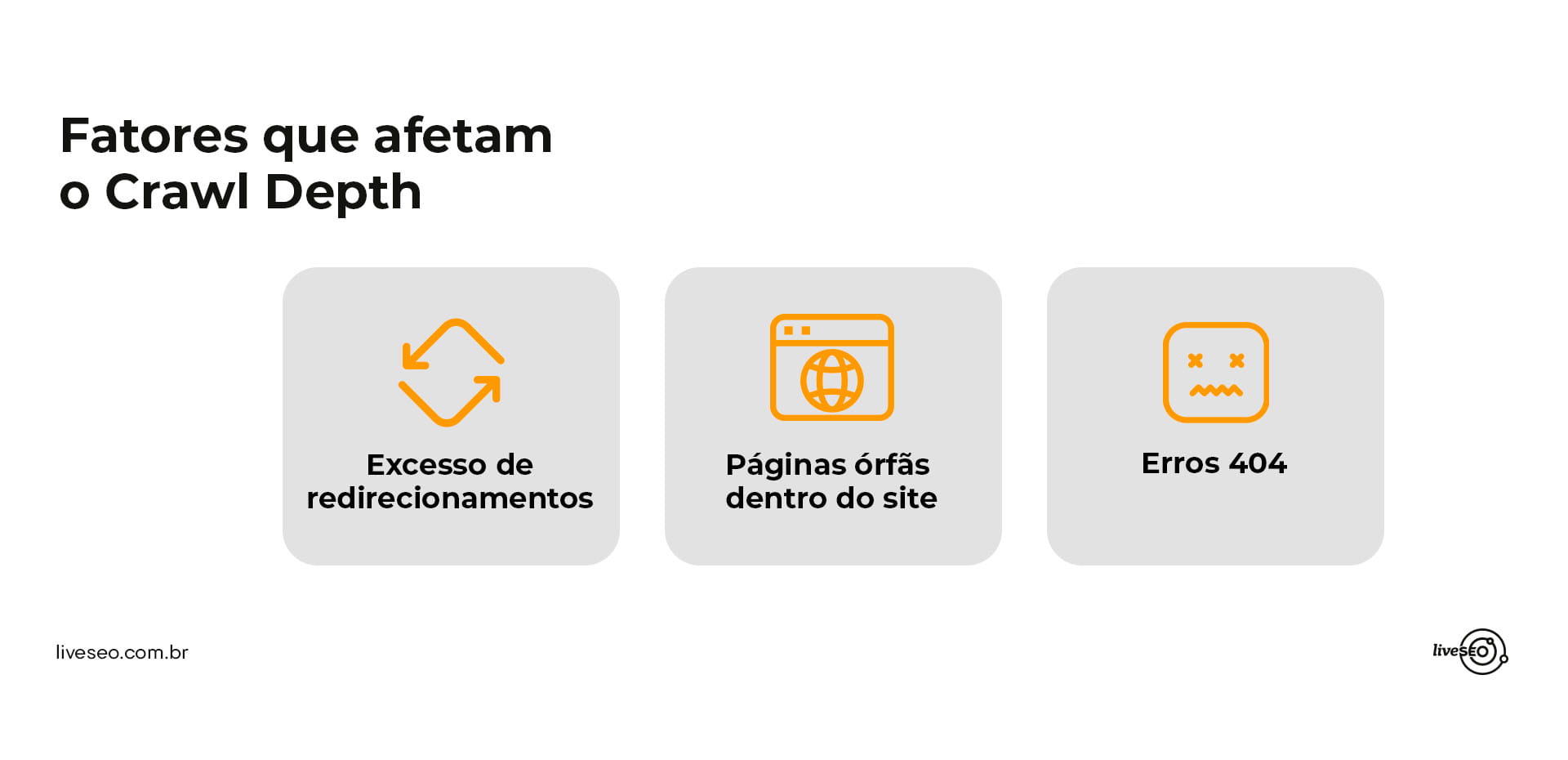

Fatores que afetam o Crawl Depth

Existem alguns pontos que podem aumentar a profundidade do rastreio; os crawlers, por exemplo, se deslocam entre um link e o outro e, se houver alguma limitação, ela influenciará diretamente no Crawl Depth.

Excesso de redirecionamentos

Com um excesso de redirects, o tempo rastreando uma única página aumenta e isso pode impedir que o crawler aproveite o orçamento disponível para seu site para descobrir outras páginas importantes.

Páginas órfãs dentro do site

As páginas órfãs são páginas que estão presentes na web, mas que não contam com nenhum outro link que os leva até elas. De uma forma geral, pode-se dizer que elas ficam isoladas e desconectadas do “mundo afora” e só podem ser acessadas ao digitar o link diretamente.

Como os crawlers apenas se deslocam através de links, é muito difícil que haja resultados e rastreamento delas sem uma linkagem com a estrutura do site.

Erros 404

Diferente de um redirect, um erro 404 pode causar um impasse para o crawler, impedindo-o de continuar seu rastreio. É como se, ao rastrear, ele se deparasse com um beco sem saída.

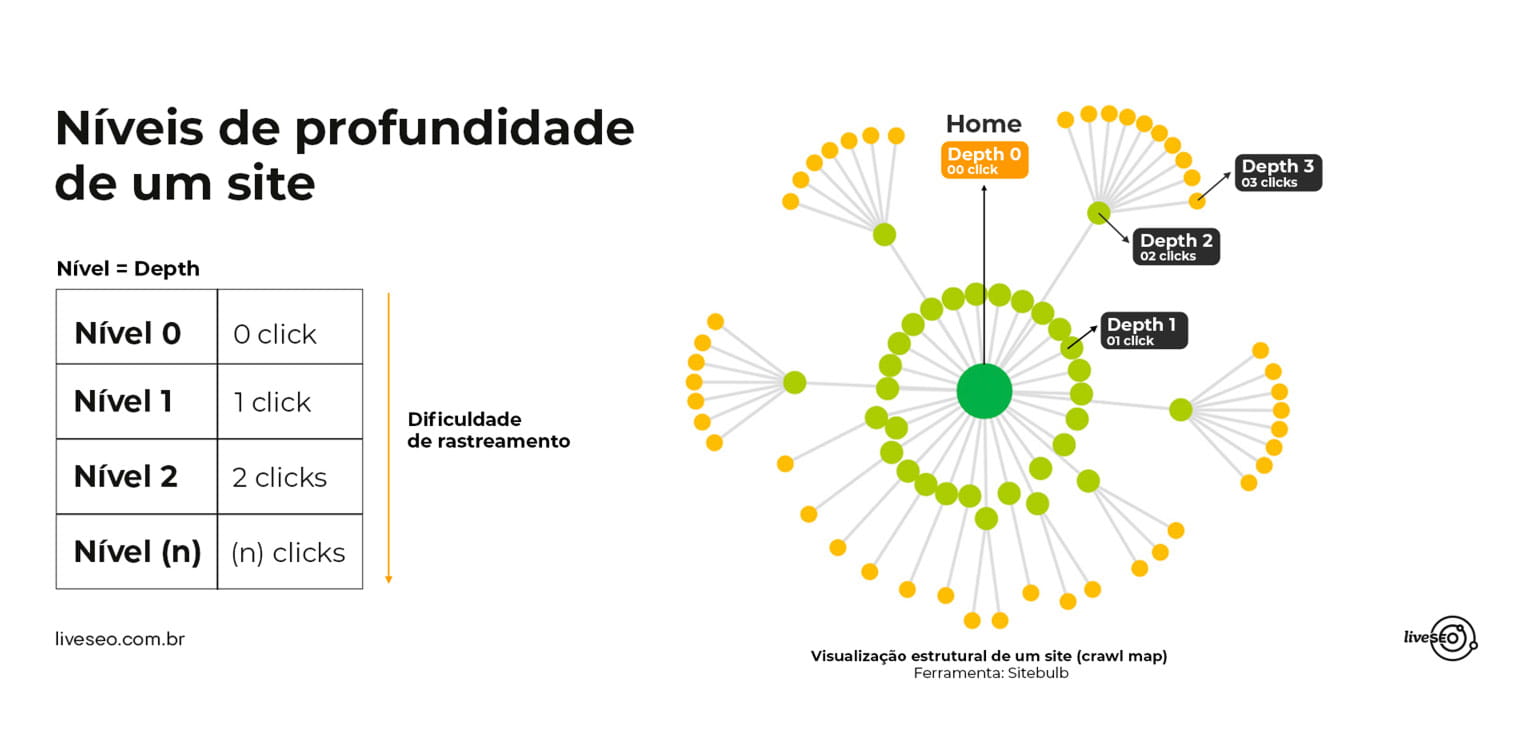

Qual a quantidade indicada de níveis de profundidade para um site?

Se eu pudesse explicar de uma forma mais didática, diria que os níveis são como um computador. A homepage seria o desktop, a porta de entrada, por isso ela é considerada nível 0.

As páginas que já vem no “sistema” ou são criadas por nós seriam consideradas de nível 1, se você criar mais uma página dentro dela passa a ser nível 2 e assim sucessivamente.

O mais indicado é conter apenas 4 níveis de páginas – no máximo. Quanto mais níveis de páginas houver dentro de um site, mais difícil que o crawler e o usuário possam chegar com facilidade a qualquer conteúdo disposto ali.

Olhe só esse exemplo de estrutura por níveis, em que o site chega a ter conteúdos até o 7º nível… Cá entre nós, quais as chances de uma página tão longe assim estar posicionada?

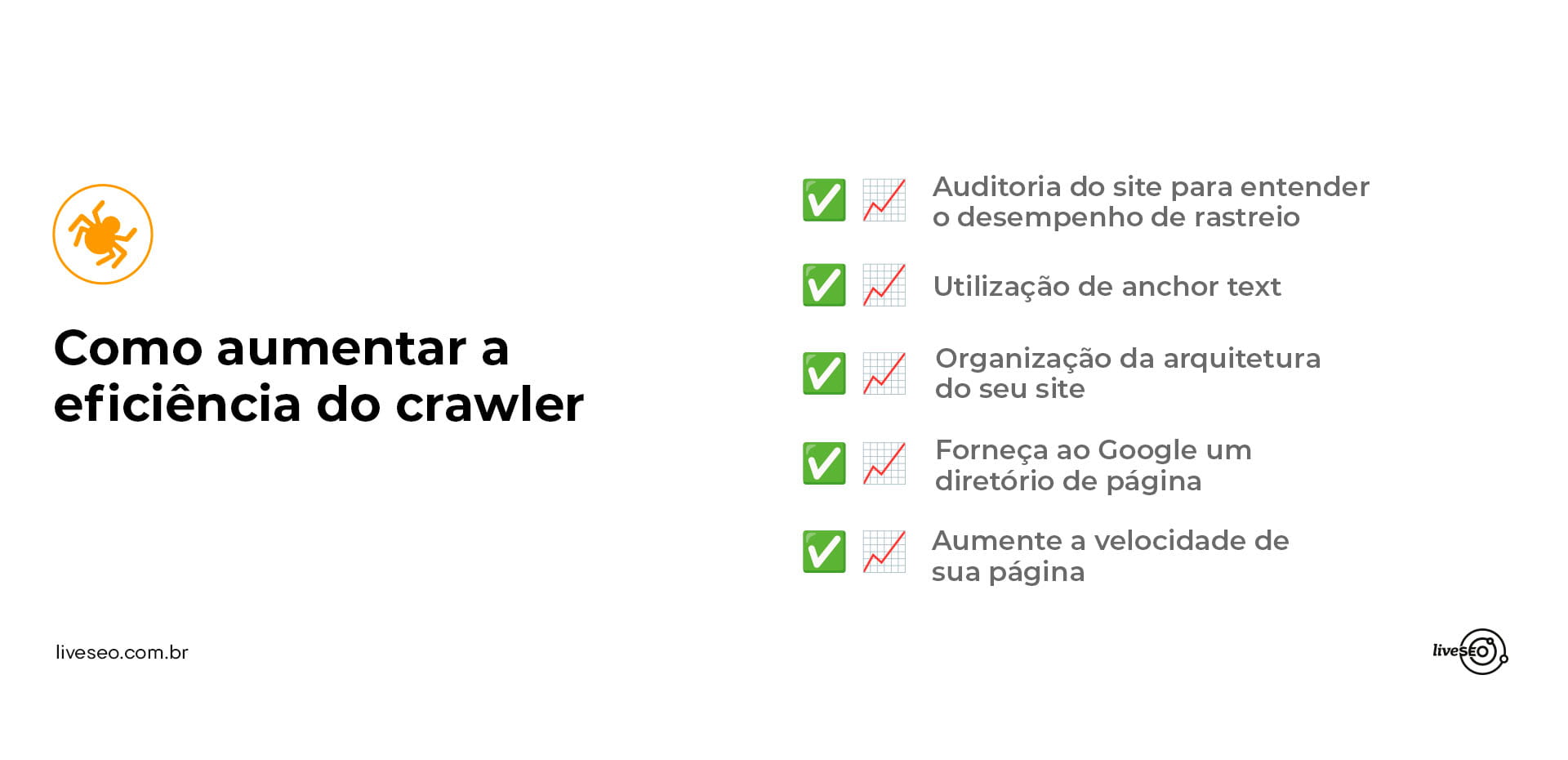

5 dicas para aumentar a eficiência do crawler em um site

O Crawl Depth é uma medida de eficiência de rastreamento, então, se existe forma de deixar o crawler ainda mais eficiente, temos algumas dicas para te dar:

1. Audite seu site e entenda como está o desempenho de rastreio

Uma das ferramentas que utilizamos por aqui é o Screaming Frog! Quem já faz parte do ecossistema de SEO a conhece e sabe como ela é útil.

Essa ferramenta é capaz de simular um rastreio, assim como o do Google. Com um relatório em mãos de como o crawler se comporta dentro de seu site, você consegue observar as principais falhas e melhorias a serem realizadas, deixando o caminho dos bots livres!

2. Utilize anchor texts

Inserir links em palavras como eu venho fazendo em diferentes pontos desse texto é uma ótima opção para trabalhar não só uma estrutura coerente, como também uma clusterização de qualidade em seus textos. Existem outras formas de inserir os links, através de botões de CTAs, banners, formatos mais genéricos ou com keywords branded, relacionadas a sua marca.

Você sabia que páginas com mais links — de qualidade, por favor — são rastreadas com mais frequência?

3. Organize a arquitetura do seu site

Algumas plataformas ao serem integradas com seu site já disponibilizam um sitemap com uma arquitetura pré-definida. Mas é interessante fazer um planejamento que seja mais adequado para o seu site em particular.

4. Forneça ao Google um diretório de páginas

É muito interessante manter um sitemap XML para fornecer ao Google um diretório das páginas que precisam ser rastreadas constantemente.

5. Aumente a velocidade de sua página

Outra dica valiosa é aumentar a velocidade de seu site. Um site responsivo reduz o tempo que os crawlers requerem para acessar e renderizar as páginas, isso resulta em mais recursos sendo acessados durante o rastreio.

Você já notou como no SEO está tudo intrinsecamente conectado? Como cada um dos conceitos que apresentamos e explicamos se relacionam? Se trabalhados e otimizados, todos esses fatores podem fazer uma grande diferença em seu site, tanto a nível de experiência do usuário quanto a concepção que o próprio Google terá dele.

Se você gostou desse conteúdo, talvez vá gostar de ler sobre o Google Everflux!

Espero que tenha gostado da leitura, até a próxima.

Câmbio, desligo.

Uma resposta

Ótimo conteúdo